La inteligencia artificial ya aprende sola a ser invencible

El último algoritmo de Google prescinde del conocimiento humano y señala que puede ser un lastre

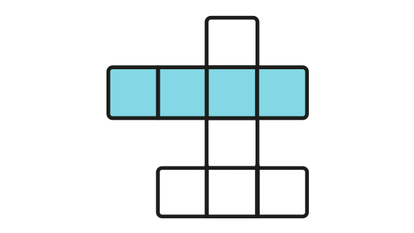

Es solo un juego de mesa. Pero el tablero del go, este complejo ajedrez oriental, es el terreno elegido para explorar las fronteras de la inteligencia artificial que en el futuro ayuden a "resolver todo tipo de problemas apremiantes del mundo real", en palabras de Demis Hassabis, líder de Google DeepMind. Esta división de la multimillonaria tecnológica ya logró crear un programa ganador de go, AlphaGo, capaz de derrotar a los campeones mundiales desnudando muchos secretos de la mente humana. Ahora han ido un paso más allá al desarrollar un programa capaz de aplastar a todas las versiones previas del todopoderoso AlphaGo aprendiendo de cero y sin ayuda. Una máquina que se enseña a sí misma, sin ejemplos de partidas reales ni intervención humana, hasta convertirse en invencible. Y además lo logró con una fuerza incomparable, en un tiempo récord y consumiendo una cantidad mínima de recursos informáticos.

Esta nueva versión desarrollada por DeepMind cuenta con un algoritmo que le permite aprender a ganar de la nada, practicando consigo misma

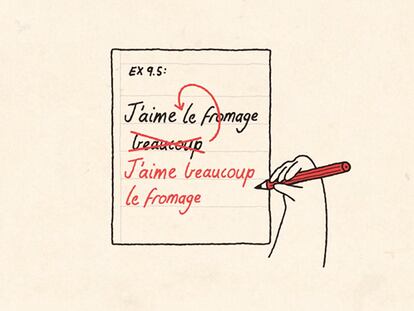

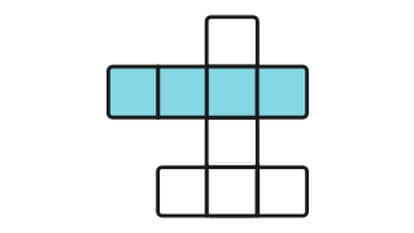

El programa original se había entrenado estudiando millones de movimientos reales de miles de partidas jugadas entre humanos, un monumental paso previo antes de comenzar a entrenarse jugando contra sí mismo hasta convertirse en imbatible. Pero esta nueva versión desarrollada por DeepMind, denominada AlphaGo Zero, cuenta con un nuevo algoritmo que le permite aprender a ganar de la nada, a solas con el tablero y las fichas. El nuevo algoritmo se apoya en una red neuronal basada en el aprendizaje por refuerzo: la máquina sabe enseñarse sola practicando consigo misma hasta alcanzar una capacidad muy superior a la de sus versiones previas.

El equipo de DeepMind quería ilustrar cómo la inteligencia artificial puede ser eficiente frente a aquellos retos en los que no se cuente con datos suficientes o conocimientos previos para guiar a la máquina hacia una solución óptima, como explican en el estudio que les publica la revista Nature. "Nuestros resultados demuestran", escriben, "que un enfoque de aprendizaje por refuerzo puro es completamente factible, incluso en los dominios más exigentes: es posible entrenar a un nivel sobrehumano, sin ejemplos humanos ni orientación, sin más conocimiento del campo que las reglas básicas". La idea ya no es superar a los humanos subiendo sobre sus hombros, sino llegar donde ellos no están ni pueden ayudar.

La máquina autodidacta derrotó a una máquina igual de potente pero enseñada con información de partidas humanas en solo 24 horas

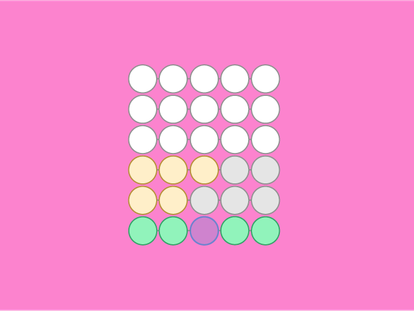

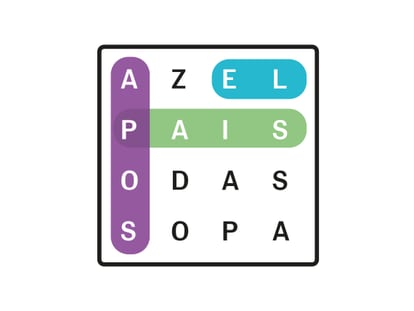

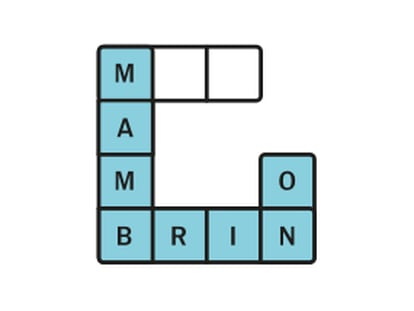

Partiendo de cero, con movimientos aleatorios, AlphaGo Zero comenzó a entender las nociones de este complejísimo juego de piedras blancas y negras que deben ir ganando territorio en un tablero de 19 por 19 cuadrantes. En solo tres días, tras jugar contra sí misma casi cinco millones de veces, esta máquina venció a la exitosa versión previa que derrotó por primera vez a un campeón de talla mundial. Aquella máquina original necesitó meses de entrenamiento y 30 millones de jugadas. El algoritmo actual es tan eficiente que se hizo invencible con tan solo cuatro chips especializados frente a los 48 que necesitaba su predecesora de 2015. AlphaGo Zero derrotó a AlphaGo por 100 a cero.

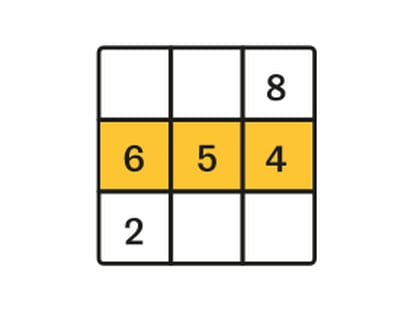

Lo más interesante es lo que esta nueva máquina nos enseña sobre el aprendizaje, sobre (lo prescindible de) nuestros conocimientos y nuestra inteligencia. "A las 3 horas, el juego se centra en comer piedras con avaricia, como un principiante humano", detalla el estudio. "A las 19 horas, el juego exhibe los fundamentos de vida y muerte, la influencia y el territorio", continúa. A las 70 horas, la máquina es extraordinariamente capaz, a niveles sobrehumanos, capaz de visualizar estrategias sofisticadas impensables para los jugadores de carne y hueso. Y en 40 días es invencible.

La idea ya no es superar a los humanos subiendo sobre sus hombros, sino llegar donde ellos no están ni pueden ayudar

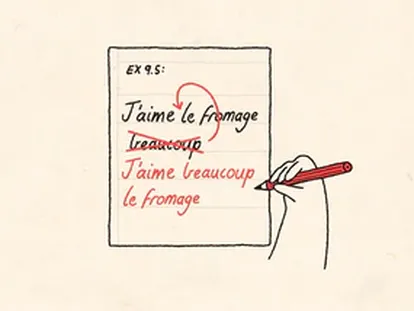

De forma intuitiva, la máquina fue descubriendo tácticas, posiciones y movimientos que el talento humano había ido perfeccionando durante miles de años. Pero descubrió por sí misma otras estrategias innovadoras desconocidas que le resultaban más eficientes y optó por abandonar los movimientos clásicos humanos. Esa creatividad del algoritmo, uno de los hallazgos más notables de DeepMind, ya pudo verse en su famosa batalla contra el campeón Lee Sedol, de quien siempre se recordará su gesto, ojiplático y boquiabierto, al observar un brillante movimiento ganador de AlphaGo.

Es más, AlphaGo Zero ha demostrado que el conocimiento humano puede incluso ser un lastre a la hora de alcanzar mayores niveles de efectividad. Los especialistas de DeepMind alimentaron a una copia de este algoritmo con información de partidas reales entre humanos, para comparar su rendimiento con la versión autodidacta. El resultado: la máquina autodidacta derrotó a la máquina enseñada por humanos en las primeras 24 horas de entrenamiento. "Esto sugiere que AlphaGo Zero puede estar aprendiendo una estrategia que es cualitativamente diferente del juego humano", concluyen los investigadores de Google.

La verdadera capacidad de las máquinas

DeepMind ya había logrado que las máquinas aprendieran solas a ganar, como hizo con videojuegos clásicos. Pero el nivel de sofisticación del go, con más posibilidades en el tablero que átomos en el universo, lo convierte en mejor prueba que los marcianitos. Sobre todo si, como asegura Hassabis, pretenden usar estos desarrollos para solucionar cuestiones tan difíciles como el plegamiento de proteínas o el desarrollo de nuevos materiales: "Si podemos lograr con estos problemas el mismo progreso que con AlphaGo, tiene el potencial de impulsar el conocimiento humano e impactar positivamente en todas nuestras vidas"

"AlphaGo Zero puede estar aprendiendo una estrategia que es cualitativamente diferente al juego humano", concluyen los investigadores de Google

Conocidos los resultados de DeepMind, conviene recordar la Ley de Amara, propuesta por el científico Roy Amara: "Tendemos a sobrestimar el efecto de una tecnología a corto plazo y subestimar su efecto en el largo plazo". Este algoritmo de Google no tiene rival a la hora de enseñarse a sí mismo a ganar al go, pero hoy por hoy está muy limitado por la tarea encomendada. Así lo reconocieron sus desarrolladores hace unos meses, preguntados por qué pasaría si de pronto le cambiaran a AlphaGo las dimensiones del tablero de 19x19 a 29x29: "Estaríamos muertos". Un jugador humano sabría adaptarse sin mayores problemas al cambio.

Como contexto, un estudio del mes pasado publicado por investigadores de la Academia de Ciencias de China sobre el riesgo real de la inteligencia artificial analizando sus actuales capacidades. Así, estudiaron cuál sería el coeficiente intelectual de los distintos sistemas de inteligencia artificial, llegando a la conclusión de que son como niños pequeños: el de Google es de 47, el doble que el de Siri (24). Tomando en consideración las habilidades de los sistemas en torno a su "dominio del conocimiento, aprendizaje, uso y creación", llegaron a la conclusión de que la inteligencia general de AlphaGo (la versión de 2016) está por debajo de la humana. Eso sí, señalaban que para subir un peldaño en sus capacidades intelectuales AlphaGo necesitaba demostrar la creatividad necesaria para enseñarse a sí mismo a ganar. Y ese reto ya lo ha superado.

Sobre la firma